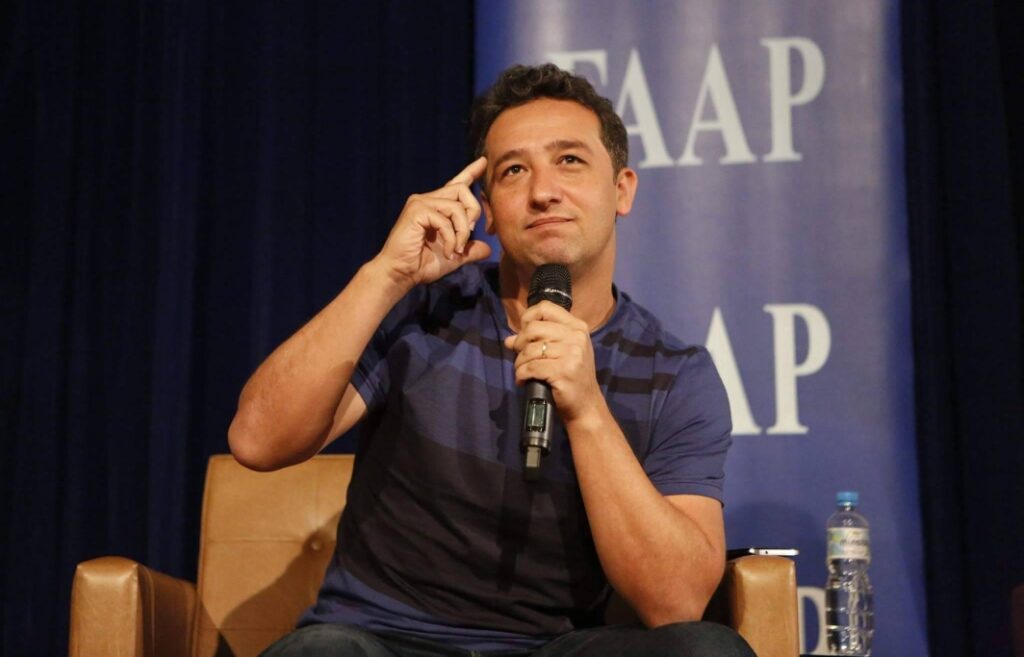

Professor da Ufes, Fábio Malini alerta para falta de transparência das plataformas digitais

Uma sociedade que se alimenta abundantemente de mentiras está exposta a que tipo de perigos? A resposta para essa pergunta já foi apresentada, na prática, diversas vezes – lmebremos, por exemplo, das mortes por Covid-19 durante a pandemia, com uma parte siginificativa delas decorrentes da disseminação de medidas de prevenção ou tratamento sem embasamento científico. Essa questão voltou ao centro das discussões do mundo esta semana, após um anúncio feito nessa terça-feira (7) pelo CEO da empresa estadunidense Meta, Mark Zuckerberg, informando a intenção de abolir o trabalho das agências de checagens de fatos que atuam no Facebook, Instagram e WhatsApp – plataformas digitais de sua propriedade – relegando a tarefa de moderação de conteúdo exclusivamente às “comunidades” – ou seja, aos próprios usuários dessas plataformas.

O professor do Departamento de Comunicação Social da Universidade Federal do Espírito Santo (Ufes), Fábio Malini, que coordena o Laboratório de Internet e Ciência de Dados (Labic), reconhece a relevância das “notas de comunidade” a que Zuckerberg faz referência, e o quanto esse sentido de “comunitarismo” está na gênese da internet – sendo isso um diferencial positivo da web em relação aos tradicionais meios de comunicação de massa, devido à maior horizontalidade com que a informação pode circular em determinados nichos das plataformas digitais. Mesmo assim, Malini alerta para os perigos produzidos pela crescente falta de transparência no acesso a dados e informações dessas plataformas, que, somada à ausência de moderação e à saída das agências de checagem de fatos, tende a criar um cenário preocupante em diversos aspectos, inclusive para a segurança e a vida das pessoas.

“As notas de comunidade têm um papel importante. Eu acredito muito nessa capacidade compartilhada, na força comunitarista, esse elemento mais horizontal de produção do verdadeiro, que é histórico e muito salutar na internet. Mas a Meta cria um falso argumento, de que a substituição das empresas de checagem por notas de comunidade, como uma solução que diminui o viés político, amplifica a capacidade de liberdade de expressão da base. Isso não é um argumento muito acurado, porque também as notas de comunidade podem ser caracterizadas por vieses de diferentes grupos sociais, podem tornar a plataforma muito tóxica com grande volume de desinformação, o que aconteceu com o Facebook. Por isso que, em geral, os bons exemplos são com moderação: as notas de comunidade são feitas, mas existem metamoderações que ajudam a editar essas notas de comunidade e tornam mais saudável aquele ambiente”, pondera.

Fábio Malini acentua que a discussão em tela “passa muito pelo futuro de regulação”, onde se consideram cenários distintos: “a ausência de regulação, que é quase um princípio norte-americano; a regulação mais pesada, que vem da legislação europeia já vigente; e a quase regulação no Brasil, que aponta para uma judicialização da regulação, que passa pelo STF [Supremo Tribunal Federal] e o julgamento da constitucionalidade do artigo do Marco Civil que trata do tema da liberdade de expressão e da responsabilidade das plataformas”.

Regulação é fundamental por diversas razões, entre elas, o movimento de crescente agravamento da falta de transparência quanto ao acesso a dados e informação por parte das plataformas nos últimos três ou quatro anos, “especialmente em lugares onde não existe sistema de regulação dessas empresas”, pontua.

“Caixa-preta”

Pouco se sabe, por exemplo, como de fato funciona a gestão algorítmica das plataformas, que leva o usuário a ser exposto aos assuntos – seja em vídeos, textos ou imagens – que ele demonstra ter mais interesse, por se demorar mais diante da tela para consumi-los. O que se sabe, diz Malini, é que a partir de 2015, a lógica das plataformas mudou drasticamente, saindo do foco no usuário produtor de conteúdo – o perfil, o autor, a conta – para o tema consumido. Inicialmente, explica, para ter sucesso nas redes sociais da internet, o influenciador precisava ter muitos seguidores e amigos, e que esses iriam consumir o que tinha sido produzido.

“Nessa toada, as plataformas tiveram no Marco Civil um porto seguro, porque não poderiam ser responsabilizadas por conteúdos subidos pelo usuário e elas só poderiam agir mediante ordem judicial para remoção de conteúdo. Acontece que de 2015 para cá – e o TikTok é a principal referência dessa mudança -, as plataformas passaram a criar audiências algorítmicas em que nem todo o conteúdo que você publica chega aos seus seguidores. Para chegar, ou se paga ou se acredita que a dimensão algorítimica das plataformas vai entregar o seu conteúdo. Porque, hoje, são elas que definem quem vai ser alcançado e quando esse conteúdo publicado por você vai chegar nessas pessoas. Com isso, elas passam a ter um papel de mediação muito relevante, que é na verdade um papel de editora muito relevante, mesmo que essa edição seja no campo da distribuição”, explica.

As abas “Para você” ou “For You”, inicialmente lançadas pelo TikTok, foram rapidamente copiadas pelas demais, como o Facebook e o Twitter (atual X), o YouTube, com os shorts, e o Instagram, com os Reels. “Isso significa que, de certa maneira, a gente vai ter também [com a saída das agências de checagem de fatos] um novo tipo de moderação, que vai ser algorítmica. Como a gente vai fazer para que esses algoritmos, baseados nos interesses das pessoas em um determinado momento, sejam também auditados? Porque eles são uma caixa-preta!”, questiona o pesquisador. Ele acrescenta que a desinformação também tende a seguir essa dinâmica, em que quanto mais pessoas acessam um conteúdo falso, mais os influenciadores produzem esse tipo de material e mais ele será entregue pelas plataformas. “Como vamos regular esse processo mais algorítmico?”, pergunta.

O jornalismo, acrescenta, que cumpre um papel de “defensor da verdade”, não tem capacidade para filtrar o grande volume de desinformação que já circula e tende a ser intensificado com a saída das empresas de checagem. “Existem camadas de negacionismo, de produção de ignorância, que muitas vezes são fomentados por grupos políticos. São contextos que continuarão acontecendo e, se as pessoas não têm uma dieta de informação moderada, se você tem uma sociedade que começa a crer na ignorância, em função da produção ou da dimensão algorítmica da lógica do ‘For You’, isso cria uma bola de neve, um ciclo vicioso de produção de ignorância e um sistema de crenças que impede as pessoas de acreditarem em informações checadas. Esse é o drama que a gente já está vivendo e pode piorar”.

Repercussão mundial

Para além da preocupação acadêmica com o anúncio da Meta, lideranças políticas dos poderes Executivo e Legislativo do Brasil e de outros países têm manifestado preocupação, anunciando também medidas que podem ser implementadas para impedir o enfraquecimento da checagem de fatos e controle da desinformação nas plataformas.

Os presidentes Luiz Inácio Lula da Silva (PT), do Brasil, e Emmanuel Macron, da França, alinharam, nesta sexta-feira (10), intenção de unir esforços, junto a outros países da Europa, para impedir a ameaça às democracias pelo aumento de mentiras em circulação na internet. Na mesma data, a Advocacia Geral da União (AGU) notificou a Meta para que, em 72 horas, responda quais mudanças nas políticas de moderação de conteúdo pretende implementar no Brasil.

“Nós apresentaremos uma notificação judicial, e a empresa terá 72 horas para informar ao governo brasileiro qual é, de fato, a política da Meta para o Brasil”, informou o advogado-geral da União, Jorge Messias, após participar, em Brasília, de reunião com o presidente Lula e o ministro-chefe da Casa Civil, Rui Costa, conforme noticiou a Agência Brasil.

“Isso impacta de forma muito grande a sociedade brasileira. Impacta nas crianças, quando se fala de conteúdo impróprio e de tráfico de crianças. Impacta na segurança pública, quando se trata de informações que dizem respeito à segurança das pessoas, à prática criminosa”, disse Costa. Ele citou também exemplos de impacto envolvendo os mais diversos tipos de discriminação por raça, credo, gênero e regional, que acabam por promover discursos de ódio.

O ministro mencionou ainda o caso do uso da inteligência artificial para produzir um vídeo com informações falsas atribuídas ao ministro da Fazenda, Fernando Haddad – a Meta retirou o vídeo do ar após notificação da AGU. De acordo com Costa, vídeos como esse impactam inclusive a economia nacional. “As pessoas acabam não conseguindo distinguir o que é verdade do que é mentira. Isso acaba impactando no país, na nação, nas pessoas e na economia. Estamos falando de soberania nacional”, enfatizou.

Medida semelhante já havia sido tomada na quarta-feira (8) pelo Ministério Público Federal em São Paulo (MPF/SP), quando oficiou os representantes da Meta no Brasil, indagando se as mudanças anunciadas para os Estados Unidos, em conformidade com a linha ideológica do presidente eleito, Donald Trump, pretendem ser implementadas também no Brasil. O objetivo, explica o MPF/SP, é entender os detalhes dessas alterações, para avaliar em que medida elas podem, eventualmente, impactar direitos dos usuários destas plataformas que vivem em nosso país.

O ofício, explicou, está vinculado a um inquérito civil que a Procuradoria Regional dos Direitos do Cidadão (órgão do MPF/SP) conduz desde 2021 para investigar a conduta de plataformas digitais no enfrentamento à desinformação e à violência no mundo digital no Brasil. “O procedimento visa à apuração de quais medidas as empresas responsáveis por Facebook, Instagram, Twitter, Whatsapp, Telegram, TikTok e YouTube adotam para detectar e combater ações como a produção de conteúdos falsos, o disparo de mensagens em massa e o uso de robôs e perfis fictícios. O MPF/SP vem cobrando melhorias nessas plataformas desde então”, informou.